I slutet av september presenterades rankingen av Polens alla forskningsinstitutioner. Av de 963 institutionerna fick 37 det högsta betyget, A+, och kallades av forsknings- och utbildningsminister Barbara Kudrycka för “eliten, Polens visitkort i världen.” Vilken ranking institutionerna får är mycket viktigt, eftersom tilldelningen av forskningsmedel från staten till stor del kommer att baseras på rankingen. Mitt institut hamnade just utanför de 37 – av lite oklara skäl.

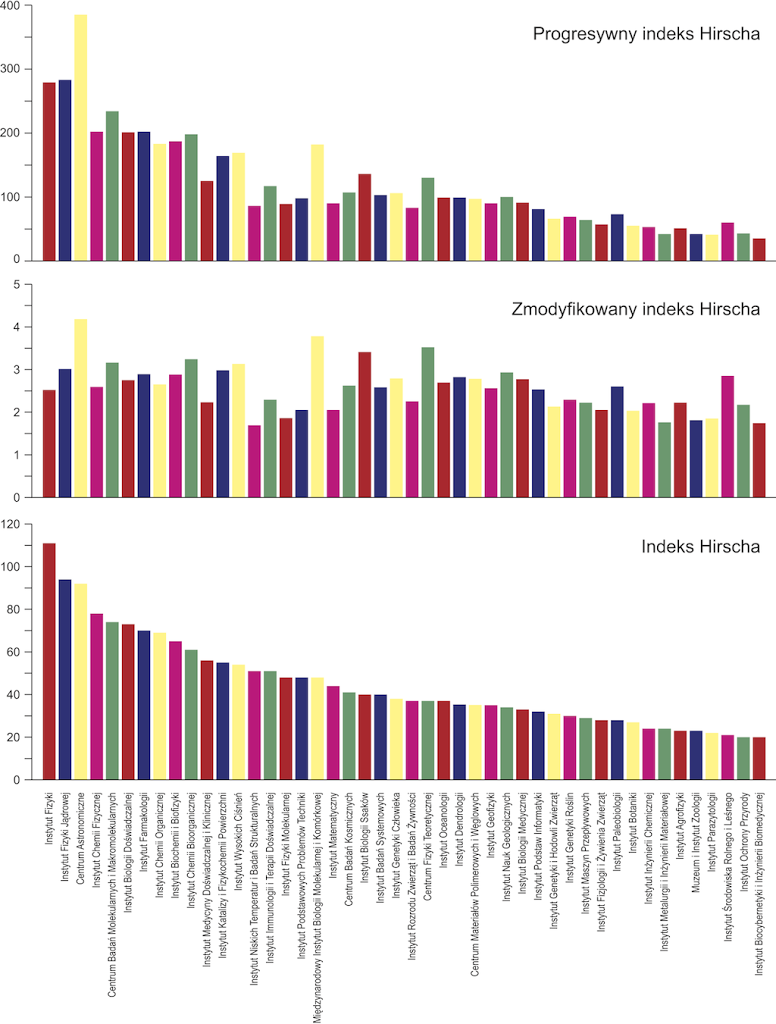

Rankingen baseras till stor del på bibliografiska data (vilket jag ofta uttryckt skepsis mot) där varje institution får en egen Hirsch-faktor. Denna modifieras på olika sätt för att få fram olika mätvärden där. Sedan jämför man hur mycket som olika institutioner citeras*. Därtill jämförs Polska vetenskapsakademiens (PAN) institut och universitetsinstitutionerna separat. Listan för Hirschvärden för PAN-instituten (bilden till vänster) toppas av Institutet för fysik. Min arbetsplats ligger fyra på listan.

Exakt vilka regler som gäller för den officiella rankingen från Kommitten för utvärdering av vetenskapliga institut är lite oklart, men åtminståne ett är klart – det är inte en helt transparent affär. Vår direktör har försökt ta reda på vad som gäller och inte lyckats. Bland annat så är den bibliografiska rankingen beroend av antalet anställda. Vi drabbas av det eftersom vi har ovanligt många anställda doktorander. Det har fått till följd att vår ledning nu överväger att anställa färre doktorander och låta fler gå på stipendium. Alltså precis tvärt emot utvecklingen i resten av Europa. Och ett mycket oönskat alternativ.

Jag läste i Tidningen Curie att man i Sverige vill införa en form av peer-review system för att bedöma forskningskvalitet hos lärosätena. Det är så klart mycket bättre än en ren bibliografisk bedömning, men det finns risker även där. Granskningen kommer att behöva vara åtminstone till del hemlig. Ett av de bedömningkriterier där vårt institut fick lågt betyg var “övriga effekter av det vetenskapliga arbetet”. Det är oklart vad som menas med det. Med reservation för att det är uppgifter från en irriterad chef för ett institut som petades ur topplistan så ryktas det om att det finns en ganska stark korrelation mellan institutionerna på A+-listan och kommittemedlemmarnas hemmainstitutioner. Det kan ju vara oskyldigt – man väljer medlemmar bland de främsta forskarna. Men, vem vet…

På något sätt måste en ranking göras, för medlen att fördela är begränsade. Och hur man än gör kommer det att finnas vinnare och förlorare. Det minsta man kan kräva är att processen skall var så öppen som möjligt. Och att den inte skall leda till taktikspel med studenters liv.

* Att det är idiotiskt att ens försöka jämföra citeringstal mellan vetenskapsfält är ytterligare ett argument mot bibliografihetsen.